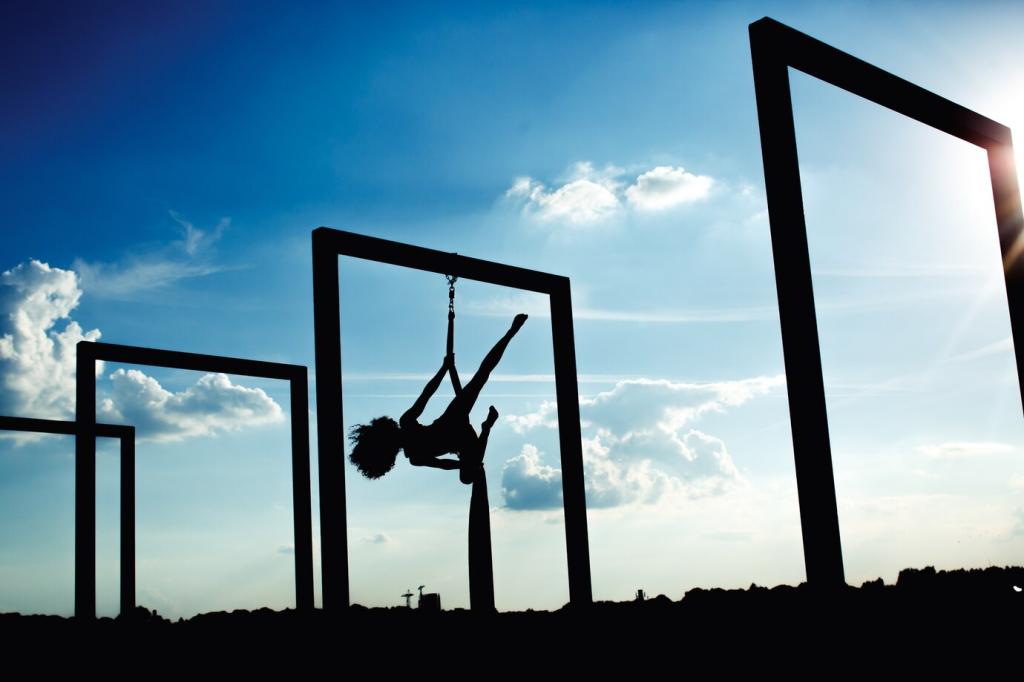

Warum KI und Datenschutzbedenken heute unvermeidbar sind

Jede Interaktion hinterlässt Spuren: Standortdaten, Klickpfade, Sprachaufnahmen. KI verknüpft diese Spuren, erkennt Muster und trifft Vorhersagen. Datenschutzbedenken entstehen, wenn Kontrolle, Transparenz und Wahlmöglichkeiten für Nutzerinnen und Nutzer fehlen.

Warum KI und Datenschutzbedenken heute unvermeidbar sind

Unternehmen, die klar kommunizieren, sparsam sammeln und Einwilligungen respektieren, gewinnen loyale Kundschaft. Schreibe uns, welche Transparenz du dir wünschst, und abonniere den Newsletter, um bewährte Vertrauensstrategien rund um KI und Datenschutzbedenken zu erhalten.